Sztuczna sieć neuronowa

Sztuczne sieci neuronowe , zwane również sztucznymi sieciami neuronowymi , w skrócie: KNN (ang. artificial neural network , ANN), to sieci sztucznych neuronów . Są przedmiotem badań w neuroinformatyce i reprezentują gałąź sztucznej inteligencji .

Sztuczne sieci neuronowe, podobnie jak sztuczne neurony, mają model biologiczny. Kontrastują je z naturalnymi sieciami neuronowymi , które reprezentują sieć neuronów w układzie nerwowym żywej istoty. SSN to bardziej abstrakcja ( modelowanie ) przetwarzania informacji, a mniej reprodukcja biologicznych sieci neuronowych i neuronów, która jest bardziej przedmiotem neuronauki obliczeniowejjest. Można jednak zaobserwować, że coraz bardziej zacierają się granice między tymi subdyscyplinami, co można przypisać wciąż dużej dynamice i interdyscyplinarności tej gałęzi badań. Motywowane biologią modelowanie jest teraz tak dobre, że wiele zadań można wykonać znacznie lepiej niż ludzie.

opis

Sztuczne sieci neuronowe opierają się głównie na sieciowaniu wielu neuronów McCulloch-Pittsa lub ich niewielkich modyfikacjach. W zasadzie w SSN mogą być również wykorzystywane inne sztuczne neurony, np. B. neuron wysokiego rzędu . Topologia sieci (Przyporządkowanie przyłączy do węzłów) musi być dobrze przemyślane w zależności od jego zadania. Po zbudowaniu sieci następuje faza szkolenia, w której sieć „uczy się”. Teoretycznie sieć może uczyć się za pomocą następujących metod:

- Rozwój nowych połączeń

- Usuń istniejące połączenia

- Zmiana wag (wagi od neuronu do neuronu )

- Dostosowanie wartości progowych neuronów, jeśli mają one wartości progowe

- Dodawanie lub usuwanie neuronów

- Modyfikacja funkcji aktywacji, propagacji lub wyjścia

Ponadto zachowanie uczenia się zmienia się, gdy zmienia się funkcja aktywacji neuronów lub szybkość uczenia się sieci. W praktyce sieć „uczy się” głównie poprzez modyfikację wag neuronów. Adaptację wartości progowej można również przeprowadzić za pomocą neuronu . W rezultacie SSN są w stanie uczyć się złożonych funkcji nieliniowych przy użyciu algorytmu „uczenia się” , który próbuje określić wszystkie parametry funkcji na podstawie istniejących wartości wejściowych i pożądanych wartości wyjściowych przy użyciu procedury iteracyjnej lub rekurencyjnej . SSN są realizacją paradygmatu koneksjonizmu , ponieważ funkcja składa się z wielu prostych części tego samego typu. Zachowanie w interakcji dużej liczby zaangażowanych części może stać się złożone dopiero po połączeniu. Pod względem przewidywalności sieci neuronowe stanowią równoważny model do maszyny Turinga, jeśli są opisane deterministycznie i dozwolone jest sprzężenie zwrotne. Innymi słowy, istnieje co najmniej jedna maszyna Turinga dla każdej sieci i co najmniej jedna sieć z informacją zwrotną dla każdej maszyny Turinga. Nie dotyczy to opisu stochastycznego. Sieci rekurencyjne są zatem najbardziej wyrazistą formą (typ 0 w hierarchii Chomsky'ego ).

rozwój historyczny

Zainteresowanie sztucznymi sieciami neuronowymi zaczęło się na początku lat czterdziestych , mniej więcej w tym samym czasie, co użycie programowalnych komputerów w matematyce stosowanej.

Początki

Początki sięgają Warrena McCullocha i Waltera Pittsa . W 1943 opisują one powiązania między jednostkami elementarnymi jako rodzaj sieci podobny do sieci neuronów, za pomocą którego można obliczyć praktycznie każdą funkcję logiczną lub arytmetyczną. W 1947 zwracają uwagę, że taką sieć można wykorzystać np. do rozpoznawania wzorców przestrzennych. W 1949 Donald O. Hebb sformułował swoją regułę Hebbowskiego uczenia się , która w swojej ogólnej formie reprezentuje większość procesów sztucznego uczenia neuronowego. W 1950 roku Karl Lashley postawił tezę, że proces przechowywania informacji w mózgu jest rozłożony na różne podjednostki.

Pierwszy rozkwit

W następnym roku, 1951, Marvin Minsky odniósł sukces w swojej pracy doktorskiej o zbudowaniu neurokomputera Snarc , który może automatycznie dostosowywać swoje wagi, ale nie jest praktyczny. W 1956 naukowcy i studenci spotykają się na konferencji w Dartmouth . Konferencja ta jest uważana za narodziny sztucznej inteligencji jako przedmiotu akademickiego. W latach 1957-1958 Frank Rosenblatt i Charles Wightman opracowali pierwszy udany neurokomputer, nazwany Mark I Perceptron . Komputer potrafił już rozpoznawać proste cyfry dzięki czujnikowi obrazu 20 × 20 pikseli. W następnym roku Rosenblatt formułuje twierdzenie o zbieżności perceptronu . 1960, Bernard Widrow'a i Marcjan E. Hoff przedstawiony na Adaline ( adaptacyjnego Linearny neuronu ). Ta sieć była pierwszą, która osiągnęła szeroką dystrybucję komercyjną. Był używany w telefonach analogowych do filtrowania echa w czasie rzeczywistym. Sieć neuronowa uczyła się za pomocą reguły delta . W 1961 roku Karl Steinbuch przedstawił techniki przechowywania skojarzeniowego. W 1969 Marvin Minsky i Seymour Papert przeprowadzili dokładną analizę matematyczną perceptronu . Pokazali, że ważnych problemów nie da się rozwiązać. Między innymi nie można rozwiązać operatorów XOR i występują problemy z liniową separowalnością . Rezultatem było tymczasowe zakończenie badań w dziedzinie sieci neuronowych, ponieważ większość funduszy na badania została anulowana.

Powolna odbudowa

W 1972 Teuvo Kohonen przedstawiony na associator liniowy , model pamięci asocjacyjnej. James A. Anderson opisuje model niezależnie od Kohonena z neuropsychologicznego punktu widzenia w tym samym roku. 1973 Christoph von der Malsburg używa się modelu neuronu , które jest nieliniowa. Już w 1974 roku Paul Werbos opracował wsteczną propagację lub śledzenie błędów w swojej pracy doktorskiej . Jednak model stał się ważniejszy dopiero później. Od 1976 roku Stephen Grossberg opracował matematyczne modele sieci neuronowych. Razem z Gail Carpenter poświęca się także problemowi utrzymania sieci neuronowej zdolnej do uczenia się bez niszczenia tego, czego już się nauczył. Formułujesz koncepcję architektury sieci neuronowych, adaptacyjną teorię rezonansu . W 1982 roku Teuvo Kohonen opisuje samoorganizujące się karty nazwane jego imieniem . W tym samym roku John Hopfield opisuje model sieci Hopfielda . W 1983 roku Kunihiko Fukushima , S. Miyake i T. Ito zaprezentowali model neuronowy neokognitronu . Model jest dalszym rozwinięciem Cognitron opracowanego w 1975 roku i służy do rozpoznawania odręcznych znaków.

renesans

W 1985 roku John Hopfield opublikował rozwiązanie problemu komiwojażera za pośrednictwem sieci Hopfield . W 1985 r. opracowano oddzielnie procedurę wstecznej propagacji uczenia się błędów jako uogólnienie reguły delta przez grupę równoległego przetwarzania rozproszonego . Tak więc problemy , których nie można oddzielić liniowo, można rozwiązać za pomocą perceptronów wielowarstwowych . Ocena Minsky'ego została zatem odrzucona.

Nowe sukcesy w konkursach rozpoznawania wzorów od 2009 roku

Ostatnio sieci neuronowe odradzają się, ponieważ często dają lepsze wyniki niż konkurencyjne metody uczenia się w wymagających zastosowaniach. W latach 2009-2012 powtarzające się lub głęboko postępujące sieci neuronowe grupy badawczej Jürgena Schmidhubera w szwajcarskim laboratorium AI IDSIA wygrały serię ośmiu międzynarodowych konkursów w dziedzinie rozpoznawania wzorców i uczenia maszynowego . W szczególności ich powtarzające się sieci LSTM wygrały trzy powiązane konkursy rozpoznawania pisma ręcznego w 2009 Intl. Konf. w sprawie analizy i rozpoznawania dokumentów (ICDAR) bez wbudowanej znajomości a priori trzech różnych języków, których należy się nauczyć. Sieci LSTM nauczyły się jednoczesnej segmentacji i rozpoznawania. Były to pierwsze międzynarodowe konkursy, które można było wygrać dzięki głębokiemu uczeniu się lub sieciom cyklicznym.

Głęboko patrzące w przyszłość sieci, takie jak sieć konwolucji Kunihiko Fukushimy z lat 80., są dziś ponownie ważne. Mają naprzemienne Konvolutionslagen ( warstwy splotowe ) i warstwy neuronów, podsumowane (kilka aktywacji łączonych warstw ) do wymiaru przestrzennego w celu zmniejszenia. Zakończony jest taki Konvolutionsnetz zwykle przez kilka w pełni połączonych warstw ( angielskie w pełni połączone warstwy ). Zespół Yanna LeCuna z New York University zastosował w takich sieciach dobrze znany algorytm wstecznej propagacji błędów . Nowoczesne warianty wykorzystują do kombinacji aktywacji tzw. max-pooling , który zawsze daje pierwszeństwo najsilniejszej aktywacji. Szybkie implementacje GPU tej kombinacji zostały wprowadzone w 2011 roku przez Dana Ciresana i współpracowników z grupy Schmidhubera. Od tego czasu wygrali wiele konkursów, w tym „ISBI 2012 Segmentation of Neuronal Structures in Electron Microscopy Stacks Challenge” oraz „ICPR 2012 Contest on mitosis Detection in Breast Cancer Histological Images”. Takie modele osiągnęły również najlepsze do tej pory wyniki w benchmarku ImageNet . Oparte na GPU sieci konwolucji z maksymalnym pulowaniem były również pierwszymi aparatami rozpoznawania sztucznych wzorców o nadludzkiej wydajności w konkursach, takich jak „IJCNN 2011 Traffic Sign Recognition Competition”.

Topologia sieci połączeń międzysieciowych

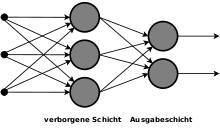

W sztucznych sieciach neuronowych topologia opisuje strukturę sieci. Ogólnie oznacza to, ile sztucznych neuronów znajduje się na ilu warstwach i jak są ze sobą połączone. Sztuczne neurony można łączyć na różne sposoby, tworząc sztuczną sieć neuronową. W tym przypadku neurony to wiele modeli w kolejnych warstwach ( ułożone warstwy angielskie ); Sieć z tylko jedną trenowalną warstwą neuronową nazywana jest siecią jednowarstwową .

Za pomocą wykresu neurony można przedstawić jako węzły, a ich połączenia jako krawędzie . Wpisy są czasami pokazywane również jako węzły.

Najdalej wysunięta warstwa sieci, wyjścia neuronowe są widoczne głównie jako tylko jedna poza siecią, tzw. warstwa wyjściowa (angielska warstwa wyjściowa ). Przednie warstwy są odpowiednio jako warstwa ukryta (w dalszej części tekstu angielska warstwa ukryta ).

Typowe konstrukcje

Struktura sieci jest bezpośrednio związana z stosowaną metodą uczenia się i odwrotnie; tylko sieć jednowarstwowa może być uczona z regułą delta ; dla kilku warstw konieczna jest niewielka modyfikacja. Sieci niekoniecznie muszą być jednorodne: istnieją również kombinacje różnych modeli w celu połączenia różnych zalet.

Istnieją sieci z czystym sprzężeniem do przodu , w których jedna warstwa jest zawsze połączona tylko z następną wyższą warstwą. Ponadto istnieją sieci, w których połączenia są dozwolone w obu kierunkach. Właściwą strukturę sieci zwykle znajduje się metodą prób i błędów , którą można wspomóc algorytmami ewolucyjnymi i odzyskiwaniem błędów .

- Jednopoziomowa sieć ze sprzężeniem zwrotnym

- Sieci jednowarstwowe z właściwością feed forward (z angielskiego for forward ) najprostsze struktury sztucznych sieci neuronowych. Mają tylko warstwę wyjściową. Właściwość feedforward oznacza, że wyjścia neuronowe są kierowane tylko w kierunku przetwarzania i nie mogą być sprzężone z powrotem przez zbocze rekurencyjne ( wykres acykliczny , skierowany ).

- Wielowarstwowa sieć z przekazywaniem informacji

- Oprócz warstwy wyjściowej sieci wielowarstwowe mają również warstwy ukryte, których dane wyjściowe, zgodnie z opisem, nie są widoczne poza siecią. Ukryte warstwy poprawiają abstrakcję takich sieci. Tylko wtedy można wielowarstwowy perceptron rozwiązać ten XOR problem.

- Sieć cykliczna

- W przeciwieństwie do tego, sieci rekurencyjne mają również zbocza wsteczne (rekurencyjne) ( pętle sprzężenia zwrotnego ), a zatem zawierają sprzężenie zwrotne . Takie krawędzie są następnie zawsze wyposażone w opóźnienie czasowe (w teorii systemu określane jako element opóźniający), dzięki czemu, dzięki przetwarzaniu krok po kroku, wyjścia neuronowe z poprzedniej jednostki mogą być ponownie zastosowane jako wejścia. Te sprzężenia zwrotne umożliwiają sieci zachowywanie się dynamicznie i zapewniają jej pamięć .

W pewnych obszarach mózgu ssaków - a także innych kręgowców, takich jak ptaki śpiewające - neurony są formowane i integrowane z siecią neuronową nie tylko w stadiach rozwojowych, ale także w wieku dorosłym (patrz neurogeneza dorosłych , zwłaszcza w hipokampie ). Próbując sztucznie symulować takie procesy w sieciach neuronowych, modelowanie osiąga swoje granice. Ewolucyjny algorytm , podobny do Automat Moore'a , można określić, jak często neuron musi być aktywowany tak, że nowe neurony tworzą w środowisku. Należy jednak tutaj również określić, w jaki sposób nowe neurony mają zostać zintegrowane z istniejącą siecią. Tego typu sztuczne sieci neuronowe muszą nieuchronnie działać bez tworzenia warstw. Potrzebujesz całkowicie wolnej struktury, dla której w najlepszym przypadku przestrzeń, w której mogą znajdować się neurony, może być ograniczona.

posługiwać się

Jej szczególne właściwości sprawiają, że SSN jest interesująca dla wszystkich zastosowań, w których nie ma wyraźnej (systematycznej) wiedzy na temat problemu do rozwiązania lub nie ma go wcale . Są to m.in. B. rozpoznawania tekstu , rozpoznawanie mowy , rozpoznawanie obrazu i rozpoznawania twarzy , w którym kilkaset tysięcy do milionów pikseli muszą być konwertowane do stosunkowo niewielkiej liczby dozwolonych wyników.

Również w technologii sterowania ANN są wykorzystywane do konwencjonalnych sterowników w celu ich zastąpienia lub wartości zadanych, aby udawać, że siła prognozowania samodzielnie opracowanego w trakcie procesu jest określona. W ten sposób można również zaprojektować systemy rozmyte tak, aby były zdolne do uczenia się poprzez dwukierunkową konwersję do sieci neuronowych.

Możliwe zastosowania nie ograniczają się do obszarów związanych z technologią: podczas przewidywania zmian w złożonych systemach, sieci SSN są wykorzystywane jako wsparcie, m.in. B. do wczesnego wykrywania nadchodzących tornad lub do oceny dalszego rozwoju procesów gospodarczych.

Obszary zastosowania SSN obejmują w szczególności:

- Regulacja i analiza złożonych procesów

- Systemy wczesnego ostrzegania

- Wykrywanie błędów

- optymalizacja

- Analiza szeregów czasowych (pogoda, zapasy itp.)

- Synteza mowy

- Synteza dźwięku

- Klasyfikacja

- Przetwarzanie obrazu i rozpoznawanie wzorców

- Informatyka : Do robotyki , wirtualnych agentów i modułów AI w grach i symulacjach

- Diagnostyka medyczna , epidemiologia i biometria

- Model równań strukturalnych do modelowania relacji społecznych lub biznesowych

Pomimo tego bardzo szerokiego zakresu zastosowań, istnieją obszary, których SSN nie mogą objąć ze względu na ich charakter, na przykład:

- Przewidywanie liczb losowych lub pseudolosowych

- Faktorowanie dużych liczb

- Określanie, czy duża liczba prim jest

- Odszyfrowywanie zaszyfrowanych tekstów

Realizacje

- TensorFlow - biblioteka programów

- SNNS — symulator sieci neuronowej w Stuttgarcie

- EpsiloNN neuronowy język opisu Uniwersytetu Ulm

- OtwórzNN

Motywacja biologiczna

Podczas gdy mózg jest zdolny do masowego przetwarzania równoległego, większość dzisiejszych systemów komputerowych działa tylko sekwencyjnie (lub częściowo równolegle z komputerem). Istnieją jednak również pierwsze prototypy neuronowych architektur komputerowych, niejako chipa neuronowego, dla których pole badań sztucznych sieci neuronowych stanowi podstawę teoretyczną. Te procesy fizjologiczne w mózgu nie są symulowane, ale tylko architektura masowo równoległych sumatorów analogowych w krzem, który obiecuje lepszą wydajność w porównaniu do emulacji oprogramowania.

Klasy i typy SSN

Zasadniczo klasy sieci różnią się głównie pod względem różnych topologii sieci i typów połączeń, na przykład sieci jednowarstwowe, wielowarstwowe, ze sprzężeniem do przodu lub sprzężenia zwrotnego.

- McCulloch-Pitts Nets

- Matryca uczenia się

- Perceptron

- Mapy samoorganizujące się (także sieci Kohonena ) (SOM)

- Rosnący gaz neuronowy (GNG)

- Nauka kwantyzacji wektorowej (LVQ)

- Maszyna Boltzmanna

- Kaskadowe sieci korelacji

- Sieci kontrpropagacyjne

- Probabilistyczne sieci neuronowe

- Radialne sieci funkcyjne (RBF)

- Adaptacyjna teoria rezonansu (ART)

- Neokognitron

- Spikingowe sieci neuronowe (SNN)

- Sieci neuronowe z opóźnieniem czasowym (TDNN)

-

Rekurencyjne sieci neuronowe (RNN)

- Dwukierunkowa pamięć asocjacyjna (BAM)

- Sieci Elmana (również prosta sieć rekurencyjna, SRN)

- Sieci jordańskie

- Oscylująca sieć neuronowa

- Resztkowe sieci neuronowe

Funkcja aktywacji

Każda warstwa ukryta i warstwa wyjściowa lub jej neurony mają swoją własną funkcję aktywacji. Mogą być liniowe lub nieliniowe. Nieliniowe funkcje aktywacji sprawiają, że sieć jest szczególnie wydajna.

Proces uczenia

Metody uczenia służą do modyfikowania sieci neuronowej w taki sposób, aby generowała wzorce wyjściowe powiązane z określonymi wzorcami wejściowymi. Odbywa się to zasadniczo na trzy różne sposoby.

Nadzorowana nauka

W uczeniu nadzorowanym SSN otrzymuje wzorzec wejściowy, a dane wyjściowe generowane przez sieć neuronową w jej bieżącym stanie są porównywane z wartością, którą powinna faktycznie wyprowadzić. Porównując wynik docelowy i rzeczywisty, można wyciągnąć wnioski na temat zmian, jakie należy wprowadzić w konfiguracji sieci. Reguła delta (znana również jako reguła uczenia się perceptronów) może być stosowana w przypadku perceptronów jednowarstwowych . Perceptrony wielowarstwowe są zwykle trenowane z propagacją wsteczną , która jest uogólnieniem reguły delta.

Nauka nienadzorowana

Nauka nienadzorowana odbywa się wyłącznie poprzez wprowadzanie wzorców, których należy się nauczyć. Sieć neuronowa zmienia się automatycznie zgodnie z wzorcami wejściowymi.Istnieją następujące zasady uczenia się:

Wzmocnione uczenie się

Nie zawsze jest możliwe posiadanie odpowiedniego zestawu danych wyjściowych dostępnego do uczenia dla każdego zestawu danych wejściowych. Na przykład agentowi, który musi się odnaleźć w dziwnym środowisku – takim jak robot na Marsie – nie zawsze można powiedzieć, która akcja jest najlepsza w danym momencie. Możesz jednak zlecić agentowi zadanie, które sam powinien rozwiązać. Po uruchomieniu testowym, które składa się z kilku kroków czasowych, agent może zostać oceniony. Na podstawie tej oceny można nauczyć się funkcji agenta.

Etap uczenia się można wykonać za pomocą różnych technik. Można tu również wykorzystać m.in. sztuczne sieci neuronowe.

Uczenie stochastyczne

- Wyżarzanie symulowane ( wyżarzanie symulowane )

Problemy ogólne

Te główne wady Ann są obecnie:

- Uczenie SSN (w ujęciu statystycznym: estymacja parametrów zawartych w modelu ) zwykle prowadzi do wielowymiarowych, nieliniowych problemów optymalizacyjnych. Podstawowa trudność w praktycznym rozwiązaniu tych problemów często polega na tym, że nie można być pewnym, czy znalazło się optymalne globalne, czy tylko lokalne. Chociaż w matematyce opracowano wiele metod optymalizacji lokalnej, które stosunkowo szybko się zbiegają (np. metody quasi-Newtona : BFGS, DFP, itp.), zbyt rzadko znajdują one optymalne rozwiązania. Czasochłonne przybliżenie do rozwiązania globalnego można osiągnąć poprzez wielokrotne powtarzanie optymalizacji z zawsze nowymi wartościami początkowymi.

- Dane treningowe muszą być zbierane lub generowane ręcznie. Proces ten może być bardzo trudny, ponieważ należy uniemożliwić sieci uczenie się właściwości wzorców, które są w jakiś sposób skorelowane z wynikiem na zbiorze uczącym, ale które nie mogą lub nie powinny być wykorzystywane do podejmowania decyzji w innych sytuacjach. Jeżeli na przykład jasność obrazów treningowych ma pewne wzorce, to sieć może już nie „zwracać uwagi” na pożądane właściwości, a jedynie klasyfikować dane na podstawie jasności. W dziedzinie społecznej z. Na przykład istnieje ryzyko kontynuacji istniejącej dyskryminacji (np. ze względu na płeć lub pochodzenie) poprzez jednostronnie wybrane dane testowe bez wystarczającego uwzględnienia faktycznie ukierunkowanych kryteriów (np. zdolności kredytowej).

- Przy zastosowaniu heurystycznego podejścia do specyfikacji sieci KNN ma tendencję do uczenia się danych treningowych po prostu na pamięć dzięki nadmiernemu uogólnieniu lub overfittingowi ( ang. overfitting ). W takim przypadku sieci nie mogą już generalizować na nowe dane. Aby uniknąć nadmiernej adaptacji, architekturę sieci należy dobierać ostrożnie. W podobny sposób problem ten istnieje również w przypadku wielu innych metod statystycznych i jest określany jako dylemat dystorsja-wariancja . Udoskonalone procedury wykorzystują wzmocnienie , maszyny wektorów wspierających lub regularyzację w celu przeciwdziałania temu problemowi.

- Kodowanie danych treningowych musi być dostosowane do problemu i, jeśli to możliwe, wybrane bez redundancji. Forma, w jakiej dane do nauczenia są prezentowane w sieci, ma duży wpływ na szybkość uczenia się i na to, czy w ogóle można się nauczyć problemu z sieci. Dobrymi tego przykładami są dane głosowe, dane muzyczne, a nawet teksty. Samo podawanie liczb, na przykład z pliku .wav do mowy, rzadko prowadzi do pomyślnego wyniku. Im dokładniej problem stwarza samo wstępne przetwarzanie i kodowanie, tym skuteczniej może go przetworzyć SSN.

- Wstępne przypisanie wagi odgrywa ważną rolę. Jako przykład, załóżmy 3-warstwową sieć feed-forward z neuronem wejściowym (plus neuron odchylenia ) i neuronem wyjściowym oraz warstwą ukrytą z N neuronami (plus neuron odchylenia). Funkcją aktywacji neuronu wejściowego jest tożsamość. Funkcją aktywacji warstwy ukrytej jest funkcja tanh . Funkcją aktywacji warstwy wyjściowej jest sigmoid logistyczna . Sieć może nauczyć się maksymalnie jednej funkcji sinus z N ekstremami lokalnymi w przedziale od 0 do 1. Kiedy nauczy się tej funkcji sinus, może nauczyć się dowolnej funkcji z tym przypisaniem wagi - nie bardziej lokalnego ekstrema niż ta funkcja sinus - z możliwym przyspieszeniem wykładniczym (niezależnie od algorytmu uczenia). Wykorzystywana jest tutaj najprostsza propagacja wsteczna bez pędu. Na szczęście można łatwo obliczyć wagi dla takiej funkcji sinus bez konieczności uczenia się jej przez sieć: Ukryta warstwa:, x = i% 2 == 0? 1: -1 ; Warstwa wyjściowa: .

Filmy dokumentalne

- Sztuczne sieci neuronowe — komputery uczą się widzieć, proste wyjaśnienie, 2017

- Sztuczne sieci neuronowe, bardziej złożone wyjaśnienie

- Sztuczne sieci neuronowe - programy edukacyjne, proste wyjaśnienie, 2017

Zobacz też

literatura

- Johann Gasteiger , Jure Zupan: Sieci neuronowe w chemii i projektowaniu leków. Wiley-VCH, Weinheim NY i wsp. 1999, ISBN 3-527-29779-0 .

- Simon Haykin: Sieci neuronowe. Kompleksowa podstawa. Wydanie drugie, wydanie międzynarodowe = przedruk. Prentice-Hall, Upper Saddle River NJ i wsp. 1999, ISBN 0-13-273350-1 .

- John Hertz, Anders Krogh, Richard G. Palmer: Wprowadzenie do teorii obliczeń neuronowych. Podkreślenie. Addison-Wesley, Reading MA i inni 1999, ISBN 0-201-51560-1 ( badania Instytutu Santa Fé w naukach o złożoności. Przypisy do wykładu 1 = Seria obliczeń i systemów neuronowych ).

- Teuvo Kohonen : Samoorganizujące się mapy. Wydanie III. Springer, Berlin i wsp. 2001, ISBN 3-540-67921-9 ( Seria Springer in Information Sciences 30 = Fizyka i astronomia biblioteka internetowa ).

- Rudolf Kruse , Christian Borgelt, Frank Klawonn , Christian Moewes, Georg Ruß, Matthias Steinbrecher: Inteligencja obliczeniowa. 1. wydanie, Vieweg + Teubner Verlag / Springer Fachmedien Wiesbaden, 2011, ISBN 978-3-8348-1275-9 .

- Burkhard Lenze: Wprowadzenie do matematyki sieci neuronowych. Z programami użytkowymi C w Internecie. Wydanie trzecie poprawione i poprawione. Logos-Verlag, Berlin 2009, ISBN 3-89722-021-0 .

- André Lucas: Estymacja i specyfikacja ekonometrycznych sieci neuronowych. Eul, Lohmar 2003, ISBN 3-89936-183-0 ( seria: Quantitative Ökonomie 138), (również: Köln, Univ., Diss., 2002).

- Heinz Rehkugler, Hans Georg Zimmermann: Sieci neuronowe w gospodarce. Podstawy i aplikacje finansowe. Vahlen, Monachium 1994, ISBN 3-800-61871-0 .

- Günter Daniel Rey, Karl F. Wender: Sieci neuronowe. Wprowadzenie do podstaw, zastosowań i analizy danych. Hogrefe AG, Berno 2018, wydanie trzecie, ISBN 978-34568-5796-1 ( podręcznik psychologii ).

- Helge Ritter , Thomas Martinetz , Klaus Schulten: Obliczenia neuronowe i mapy samoorganizujące się. Wstęp. Addison-Wesley, Reading MA 1992, ISBN 0-201-55442-9 ( seria obliczeń i systemów neuronowych ).

- Raúl Rojas : Teoria sieci neuronowych. Systematyczne wprowadzenie. 4. poprawiony przedruk. Springer, Berlin i wsp. 1996, ISBN 3-540-56353-9 ( podręcznik Springera ).

- Andreas Zell: Symulacja sieci neuronowych. 4. Niezmieniony przedruk. Oldenbourg, Monachium i wsp. 2003, ISBN 3-486-24350-0 .

linki internetowe

- Wprowadzenie do podstaw i zastosowań sieci neuronowych

- „Spojrzenie na sieci neuronowe , 1 lipca 2019, w: Instytut Telekomunikacji Fraunhofera

- „Sieci neuronowe: wprowadzenie”, Nina Schaaf, 14 stycznia 2020 , w: Informatik Aktuell (magazyn)

- Krótki przegląd sieci neuronowych - podstawowy skrypt dla wielu typów / zasad uczenia się sieci neuronowych, wiele ilustracji, prosto napisany, ok. 200 stron ( PDF ).

- Dobre wprowadzenie do sieci neuronowych (angielski)

Indywidualne dowody

- ↑ - ( Pamiątka z 2 maja 2013 w Internet Archive )

- ↑ http://www.dkriesel.com/science/neural_networks , od 14 kwietnia 2016 r.

- ^ Warren S. McCulloch i Walter Pitts: Rachunek logiczny idei immanentnych w aktywności nerwowej . Wyd.: Biuletyn Biofizyki Matematycznej. Vol. 5 wydanie. Wydawnictwo Akademickie Kluwer, 1943, s. 115-133 , doi : 10.1007 / BF02478259 .

- ↑ a b Sieci neuronowe - Wprowadzenie. Źródło 5 września 2015 .

- ↑ Erhard Konrad: O historii sztucznej inteligencji w Republice Federalnej Niemiec (PDF; 86 kB), dostęp 23 maja 2019 r.

- ^ Bernhard Widrow, Marcian Hoff : Adaptacyjne obwody przełączające. W: Postępowanie WESCON. 1960, ZDB -ID 267416-6 , s. 96-104.

- ^ Marvin Minsky , Seymour Papert : Perceptrony. Wprowadzenie do geometrii obliczeniowej. MIT Press, Cambridge MA i wsp. 1969.

- ^ Teuvo Kohonen: Pamięci macierzy korelacji. W: transakcje IEEE na komputerach. C-21, 1972, ISSN 0018-9340 , str. 353-359.

- ↑ James A. Anderson: Prosta sieć neuronowa generująca interaktywną pamięć. W: Biologia matematyczna. 14, 1972, ISSN 0025-5564 , s. 197-220.

- ↑ 2012 Wywiad z Kurzweil AI ( Memento z 31 sierpnia 2018 w Internet Archive ) z Jürgenem Schmidhuberem na temat ośmiu konkursów, które jego zespół Deep Learning wygrał w latach 2009-2012

- ↑ Alex Graves, Jürgen Schmidhuber: Rozpoznawanie pisma ręcznego w trybie offline za pomocą wielowymiarowych, powtarzalnych sieci neuronowych. W: Yoshua Bengio, Dale Schuurmans, John Lafferty, Chris KI Williams, Aron Culotta (red.): Advances in Neural Information Processing Systems 22 (NIPS'22), 7-10 grudnia 2009, Vancouver, BC. Fundacja Neuronowych Systemów Przetwarzania Informacji (NIPS), 2009, s. 545-552

- ↑ A. Graves, M. Liwicki, S. Fernandez, R. Bertolami, H. Bunke, J. Schmidhuber: nowatorski system koneksjonistyczny dla ulepszonego nieograniczonego rozpoznawania pisma ręcznego. IEEE Transactions on Pattern Analysis and Machine Intelligence, tom 31, nr 5, 2009.

- ^ Y. Bengio: Nauka głębokich architektur dla AI. ( Pamiątka z 21 marca 2014 r. w archiwum internetowym ) Now Publishers, 2009.

- ^ Jürgen Schmidhuber : Mój pierwszy system głębokiego uczenia się z 1991 r. + Oś czasu głębokiego uczenia 1962-2013.

- ↑ K. Fukushima: Neocognitron: Model samoorganizującej się sieci neuronowej dla mechanizmu rozpoznawania wzorców, na który nie ma wpływu zmiana pozycji . W: Cybernetyka biologiczna . 36, nr 4, 1980, s. 93-202. doi : 10.1007 / BF00344251 .

- ↑ Dominik Scherer, Andreas Müller, Sven Behnke: Ocena operacji puli w architekturach konwolucyjnych do rozpoznawania obiektów . W: Sztuczne sieci neuronowe - ICANN 2010 (= Notatki do wykładu z informatyki ). Springer Berlin Heidelberg, 2010, ISBN 978-3-642-15825-4 , s. 92-101 , doi : 10.1007 / 978-3-642-15825-4_10 ( springer.com [dostęp 26 sierpnia 2019]).

- ↑ Y. LeCun, B. Boser, myśliciele JS, D. Henderson, RE Howard, W. Hubbard, LD Jackel : wsteczna propagacja stosowana do ręcznego rozpoznawania kodów pocztowych. W: Obliczenia neuronowe. Tom 1, 1989. s. 541-551.

- ↑ M. Riesenhuber, T. Poggio: Hierarchiczne modele rozpoznawania obiektów w korze mózgowej. W: Neuronauka przyrody. 1999.

- ^ DC Ciresan, U. Meier, J. Masci, LM Gambardella, J. Schmidhuber: Elastyczne, wysokowydajne splotowe sieci neuronowe do klasyfikacji obrazów. Międzynarodowa wspólna konferencja na temat sztucznej inteligencji (IJCAI-2011, Barcelona), 2011.

- ↑ D. Ciresan, A. Giusti, L. Gambardella, J. Schmidhuber: Głębokie sieci neuronowe Segment błon neuronalnych w obrazach mikroskopii elektronowej. W: Postępy w neuronowych systemach przetwarzania informacji (NIPS 2012), Lake Tahoe, 2012.

- ↑ D. Ciresan, A. Giusti, L. Gambardella, J. Schmidhuber: Wykrywanie mitozy w obrazach histologicznych raka piersi przy użyciu głębokich sieci neuronowych. MICCAI 2013.

- ↑ A. Krizhevsky, I. Sutskever, GE Hinton: Klasyfikacja ImageNet z głębokimi splotowymi sieciami neuronowymi. NIPS 25, MIT Press, 2012.

- ^ MD Zeiler, R. Fergus: Wizualizacja i zrozumienie sieci splotowych. 2013. arxiv : 1311.2901

- ^ DC Ciresan, U. Meier, J. Schmidhuber : Wielokolumnowe głębokie sieci neuronowe do klasyfikacji obrazów. Konf. IEEE w sprawie wizji komputerowej i rozpoznawania wzorców CVPR 2012.

- ^ DC Ciresan, U. Meier, J. Masci, J. Schmidhuber: Wielokolumnowa głęboka sieć neuronowa do klasyfikacji znaków drogowych. Sieci neuronowe, 2012.

- ↑ Często zadawane pytania dotyczące sieci neuronowych. Dostęp 24 lipca 2019 r .

- ↑ Często zadawane pytania dotyczące sieci neuronowych. Źródło 5 września 2015 .

- ↑ Johannes Merkert: Sam zbudowałem sztuczną sieć neuronową. W: c't. Źródło 24 maja 2016 .